Rechtliche Aspekte, von Urheberrechtsfragen über Haftung bis zu Regulierung, spielen im Kontext generativer KI eine zentrale Rolle in den Medien. Als Nutzer einer generative KI – als Unternehmen, aber auch als Softwareentwickler – können wir uns davon leider nicht ganz frei machen.

Bevor wir tiefer in konkrete Anwendungsfälle einsteigen, setzt sich dieser Beitrag mit der Frage auseinander, was wir überhaupt tun dürfen, und was wir dabei zu beachten haben.

DISCLAIMER: Die folgenden Aussagen basieren auf Recherchen und Interpretationen; sie stellen keine Rechtsberatung dar.

Aktuell viel diskutiert werden Urheberrecht, Haftungsfragen und anstehende Regulierungen.

Erstere machen sich an den Daten und dem Kontext fest:

- Die für das Training genutzten Daten.

- Die Daten, die ich an die KI übergebe.

- Die von der KI produzierten Daten.

Trainingsdaten

Modelle müssen trainiert werden und dafür werden extrem viele Daten benötigt. OpenAI gibt für das Training von GPT-3 an, 570GB Daten von CommonCrawl, die englische wikipedia und zwei Buchsammlungen („Books1 and books2“) verwendet zu haben. Das ist nur halb transparent, denn über die Inhalte von “Books1 and books2” gibt es nur Vermutungen, unter anderem Project Gutenberg. Stable Diffusion für die Bildgenerierung nennt LAION als eine Quelle, eine freie Sammlung von Metadaten zu Bildern.

Grundsätzlich wähnen sich die Anbieter damit auf der sicheren Seite, weil sie öffentlich verfügbare Daten nutzen. Rechtlich scheint das auf den ersten Blick gerechtfertigt, einmal durch die Fair-Use-Klausel in den USA, zum anderen durch das Urheberrechtsgesetz (als Umsetzung einer EU-Direktive): §44b UrhG erlaubt das Data Mining.

Allerdings gibt es auch gegenteilige Indizien und Ansichten. Für GPT-4 macht OpenAI keine Angaben mehr zu den Trainingsdaten. Womöglich, weil urheberrechtlich geschützte Material verwendet wurde? Und Getty Images hat Stable Diffusion verklagt, weil zwar die Metadaten, aber die Bilder selbst eben gerade nicht frei sind. Es bleibt abzuwarten, wie entsprechende Gerichtsurteile ausfallen, und ob bzw. wie sich die Beteiligten ggf. einigen.

Daneben reagieren aber auch immer mehr Inhalteanbieter und bauen gegen die zukünftige Nutzung Schranken auf. Auf das Training zukünftiger Modelle wird sich diese Diskussion also durchaus auswirken.

Übergabe von Daten an die KI

Wenn ich im Rahmen des Trainings eines Modelles oder bei der Nutzung eines Chats Daten an die KI übergebe, stellt sich die Frage, ob ich damit Nutzungsrechte aus der Hand gebe. Wenn die Daten etwa vom Anbieter zum weiteren Training seiner Modelle verwendet würden, dann wäre das ein Problem: Eine KI kann die Trainingsdaten prinzipiell eins-zu-eins in seinen Antworten reproduzieren. (Die Kriterien des Konkurrenten für die Kreditvergabe? Interesse?)

Spätestens wenn die Daten DSGVO-relevant sind, ergibt sich das Problem allein schon daraus, dass die meisten Anbieter in den USA sitzen.

Schaut man sich die Lizenzbedingungen der Anbieter an, so findet man eine bunte Mischung von „wir nutzen die Daten zum Training“ über “manchmal” bis zu „gar nicht“ vor. Man muss sich die Lizenzbedingungen also im Einzelfall je Anbieter und Angebot anschauen. So unterscheiden sich etwa die Angebote von OpenAI selbst von denen im Rahmen von Azure OpenAI hinsichtlich der Lokation der gehosteten Services, der rechtlichen Zusagen und auch der SLAs.

Eines aber behalten sich alle Anbieter vor: Die Analyse der übergebenen Daten daraufhin, ob diese mit den Lizenzbedingungen – insbesondere den Restriktionen – im Einklang sind.

Anders als OpenAI bietet Microsoft das Hosting und die Verwaltung von Azure OpenAI im Europäischen Wirtschaftsraum an. (link)

Ergebnisse

Bei den Ergebnissen liegen die Dinge sowohl beim Urheberrecht als auch bei Haftungsfragen recht einfach: KI erschafft nicht und KI haftet nicht. Punkt.

Urheberrecht wird nur „persönlichen geistigen Schöpfungen“ (UrhG §2.2) gewährt – also gerade nicht den Ausgaben einer Software. Die Rechtslage in den USA ist ähnlich und dort bereits durch das U. S. Copyright Office bestätigt.

Wenn ich also Ergebnisse einer generativen KI veröffentliche, dann muss ich mir im Klaren darüber sein, dass diese Ergebnisse von jedermann frei verwendbar sind. Ggf. muss man über Bezahlschranken oder im nicht-öffentlichen Verkehr über andere vertragliche Regelungen nachdenken, um das zu verhindern.

Bzgl. Haftung ist der bekannteste Fall sicher der des Anwalts, der ChatGPT nach relevanten Urteilen für seinen Fall befragte. Die Urteile, die ChatGPT lieferte, stellten sich allerdings als Halluzinationen heraus. Der Anwalt wurde dafür belangt und mittlerweile verurteilt.

Ergo: Man sollte Ergebnisse einer generativen KI nicht ungeprüft verwenden oder veröffentlichen, wenn sich daraus rechtliche Konsequenzen ergeben.

Nebenbei: Eine Kennzeichnungspflicht für KI-generierte Inhalte könnte ihm Rahmen der Regulierung kommen.

Regulierung

Das Thema, dass uns absehbar am meisten beschäftigen wird, dürfte aber das Thema Regulierung sein; und dort insbesondere die Europäische KI-Verordnung (Artificial Intelligence/AI Act).

Die KI-Verordnung ist bereits vom EU-Parlament beschlossen und die im Rahmen des Trilogs notwenigen Beschlüsse der EU-Kommission und der Mitgliedsstaaten werden bis Jahresende erwartet. Selbst mit einer Übergangsfrist von erwarteten 2 Jahren ist das nicht mehr weit hin.

Europäische KI-Verordnung

Die KI-Verordnung basiert im Kern auf Risikoklassen für Anwendungen, die KI nutzen.

Anwendungen, die Werte der EU verletzen (etwa Grundrechte) fallen unter unannehmbares Risiko und sind per se verboten. Anwendungen, die Gesundheit, Sicherheit oder Grundrechte natürlicher Personen betreffen, fallen unter hohes Risiko. Alle anderen unter geringes oder minimales Risiko.

Beispiel: Eine Anwendung, die mit Hilfe einer KI einen Kreditantrag bewilligt oder ablehnt und diese Ablehnung auch gleich verschickt, würde vermutlich nicht zulässig sein. Wird das Ergebnis einem Sachbearbeiter übergeben – wie andere Scorings auch – so gilt die Klasse hohes Risiko.

Die Klassen sind relevant, weil sich daran entsprechende Auflagen festmachen: Dokumentationspflichten, Nachvollziehbarkeit und ähnliches. Bei hohem Risiko sind dies neben anderen:

- Transparenz und Bereitstellung von Informationen für die Nutzer.

- Korrekturmaßnahmen

Wenn mein Kreditantrag abgelehnt wird, habe ich ein Recht, die Gründe zu erfahren. Und diese dürfen sich nicht auf „die KI hat entschieden“ beschränken. Und falls die Begründung eine falsche Adresse (womöglich in einem sozialen Brennpunkt) ist, habe ich ein Recht auf Korrektur dieser Information.

Wohlgemerkt, diese Pflichten beziehen sich auf das „Hochrisiko-KI-System“, also die Anwendung als Ganzes – nicht die KI selbst. Eine KI die die notwendigen Informationen im Sinne einer Explainable AI (XAI) bereitstellt (vgl. Beitrag 1) wäre zwar eine Lösung. Wenn dies aber nicht gegeben ist, kann auch ein Post-Hoc-Verfahren wie LIME eine Rechtfertigung liefern. Und wenn einem KI-Modell die falschen Trainingsdaten nicht einfach entzogen werden können, kann auch ein simples Flag helfen: „Diesen Kunden künftig nicht durch die KI sondern nur durch einen Sachbearbeiter bewerten lassen.“

An dieser Stelle muss nochmals betont werden, dass dies keine juristische Beratung ist! Bzgl. der tatsächlichen Ausgestaltung wird man auf die endgültige Fassung und womöglich deren Interpretation durch Gerichte warten müssen.

Die KI-Verordnung schient insgesamt recht positiv aufgenommen zu werden. Man findet viele Beschreibungen des Risiko-basierten Ansatzes, aber wenig Kritik. Man kann der EU wohl zugute halten, dass sie zeitnah und (so scheint die allgemeine Einschätzung) angemessen auf das Thema generative KI reagiert.

Allerdings gibt es da noch die…

Basismodelle

Neben Anwendungen, die KI verwenden, adressiert die KI-Verordnung auch Basismodelle bzw. deren Anbieter. Diese sollen Transparenzregeln bzgl. der Trainingsdaten, Stromverbrauch beim Training und andere Auflagen einhalten.

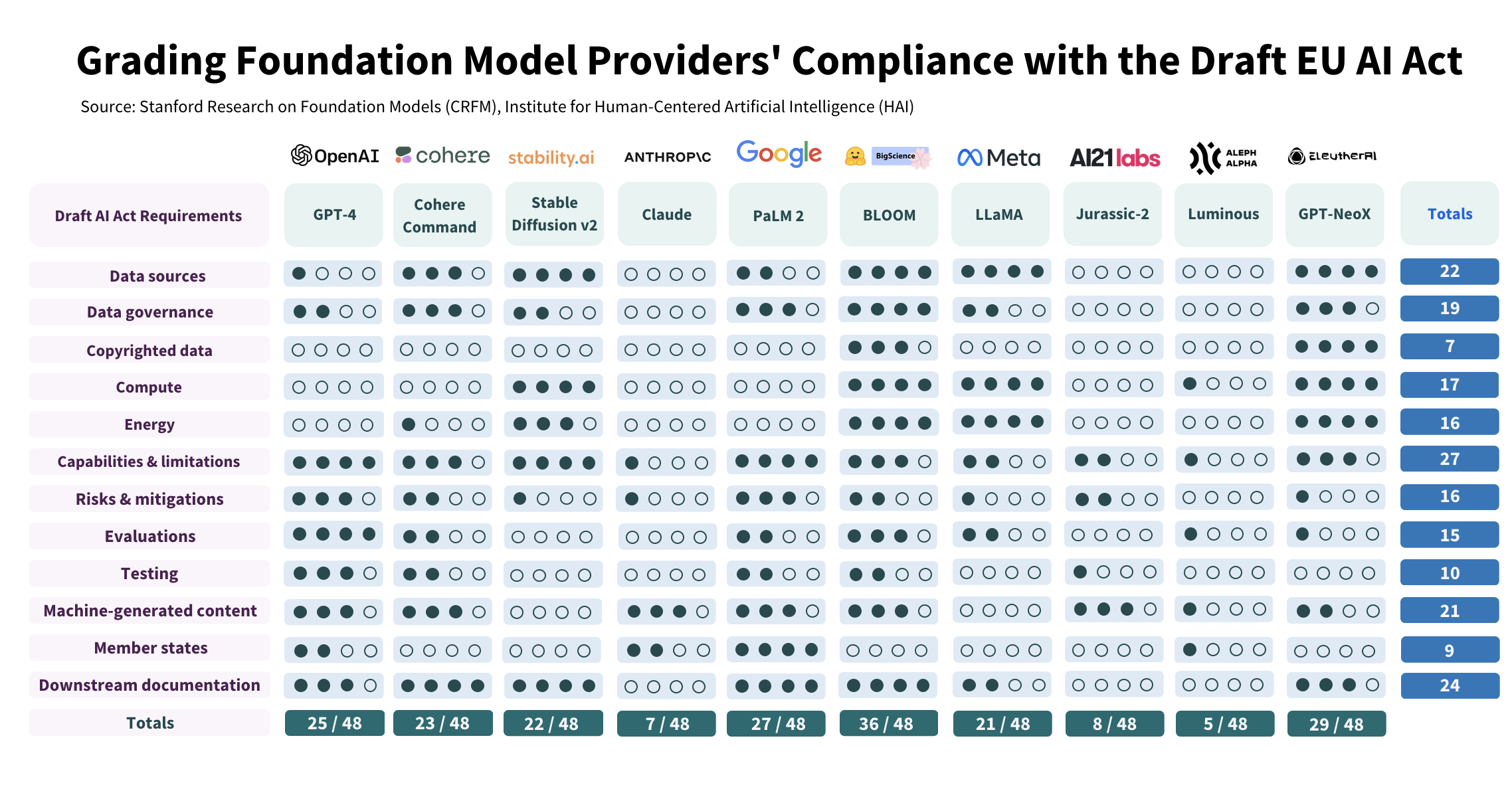

Die Stanford University hat einige Hersteller und Modelle auf Einhaltung der Regeln überprüft. Wenn man sich das Ergebnis anschaut, dann haben die Hersteller noch einige Hausaufgaben zu erledigen:

Ohne ins Detail gehen zu wollen: Man muss sich nur die Anzahl der weißen Punkte anschauen, um zu sehen, dass hier noch einiges im Argen liegt. Die Anbieter werden sich also bewegen müssen, wenn sie den Europäischen Markt nicht links liegen lassen wollen.

Wer eine Einschlaflektüre sucht, findet die Dokumente zur KI-Verordnung hier:

Internationale Regulierung

Natürlich denkt die EU nicht als einziges über die Regulierung von KI nach. International lassen sich die Bestrebungen hier in vier Gruppen aufteilen.

Am einen Ende des Spektrums sind laxe Vorgaben. Die USA haben mit dem „Blueprint for an AI Bill of Rights” (link) einen Katalog an 5 Prinzipien aufgestellt. Diesen können sich die Unternehmen im Rahmen von Selbstverpflichtungen anschließen. Nachdem die Großen der Branche bereits nach Moratorien gerufen haben (https://futureoflife.org/open-letter/pause-giant-ai-experiments/, https://www.safe.ai/statement-on-ai-risk) sollte das kein Problem sein – auch wenn andere das kritischer sehen. Japan agiert ähnlich lax wie die USA.

Am anderen Ende des Spektrums findet sich (wenig überraschend) China mit deutlich restriktiveren Regeln.

Die Europäische KI-Verordnung ordnet sich in diesem Spektrum in der Mitte ein. Und es scheint so zu sein, dass sie – ähnlich der DSGVO – Vorbildcharakter hat (“Brüssel-Effekt“), denn andere Länder diskutieren ähnliche risiko-basierte Ansätze. Beispiele: Australien, Kanada, Südkorea.

Die vierte Gruppe ist in diesem Spektrum nicht vorhanden, weil sie keine Regulierung hat oder anstrebt. Singapur tut dies z.B. bewusst, weil sie als kleines Land ohnehin wenig Einfluss haben. Bei Ländern wie Kenia – in denen viele der prekären Arbeitsplätze rund um das Training von KI-Modellen entstanden sind – würde man sich allerdings mehr wünschen.

Fazit

Bezüglich Urheberrecht sind einige Dinge im Fluss. Hier wird man aufpassen müssen, ob die Auswirkungen auf zukünftige Modelle beschränkt sein werden, oder ob auch bestehende Modelle davon betroffen sind und im Extremfall abgeschaltet werden müssen. Niemand rechnet damit, aber ausschließen kann man es eben auch nicht.

Die KI-Verordnung muss man definitiv im Auge behalten; sie dürfte eine ähnliche Bedeutung bekommen, wie die DSGVO beim Datenschutz. Dazu kommt die Strahlkraft durch ihren Vorbildcharakter. Und wenn diese international für eine Quasi-Harmonisierung sorgt, dann kann das ja nicht schlecht sein.